本篇以腾讯云的 Kafka 为例,演示如何使用明道云的 数据集成能力 订阅 Kafka 的数据 实时同步 到工作表

简要目录

- 准备 Kfaka 环境(如果已有可以跳过此部分)

- 创建同步任务

1.准备 Kfaka 环境

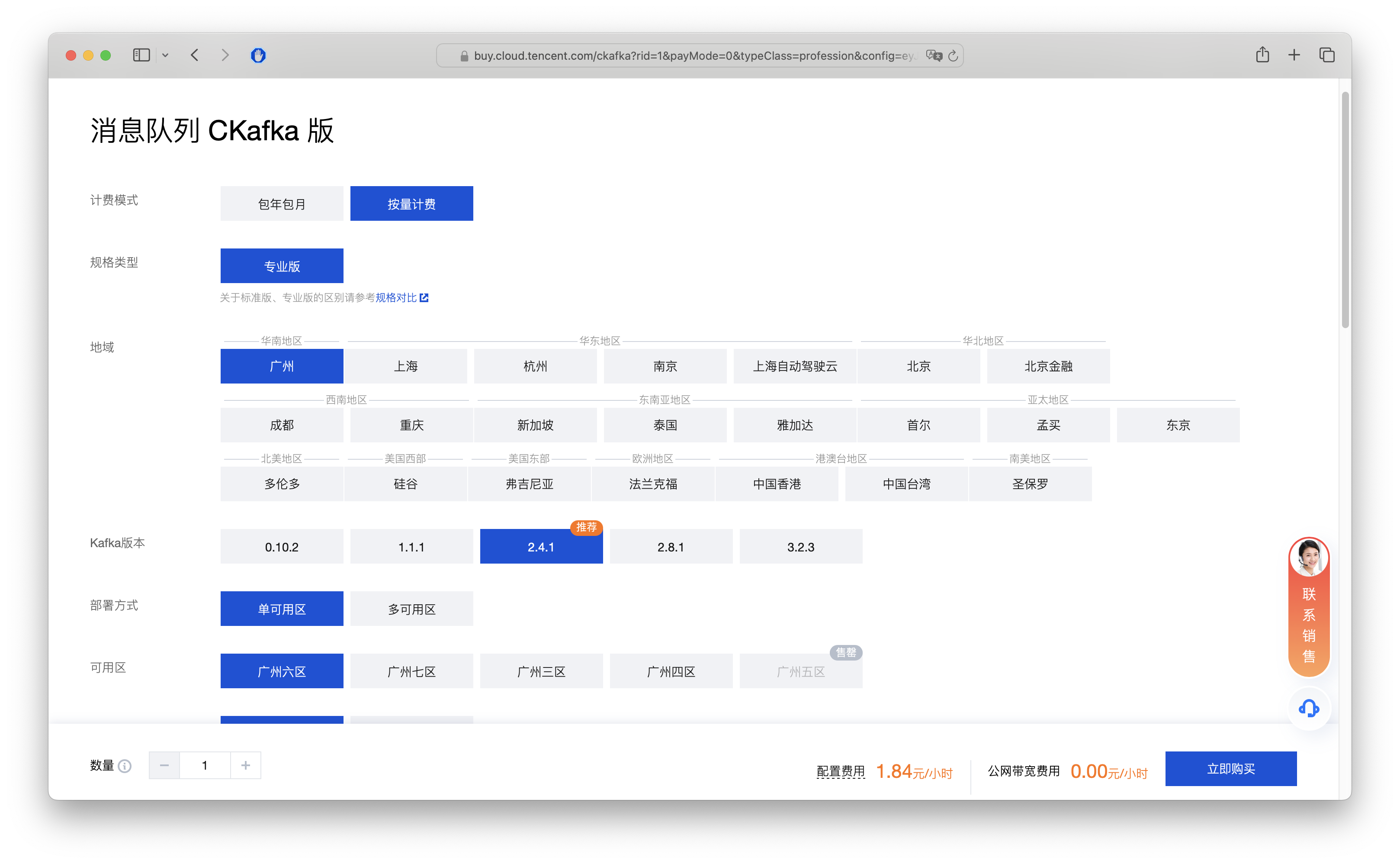

以腾讯云 Kfaka 举例子,购买地址:https://buy.cloud.tencent.com/ckafka ,当然如果有自己的 kafka 地址也可以用自己的来测试,但是注意将明道云的访问 IP(106.75.14.110, 123.59.59.220)加到白名单

- 按量付费(测试后记得及时销毁)

- 版本 2.4.1

- 免费分配独立公网 IP(用于通过明道云订阅 kafka)

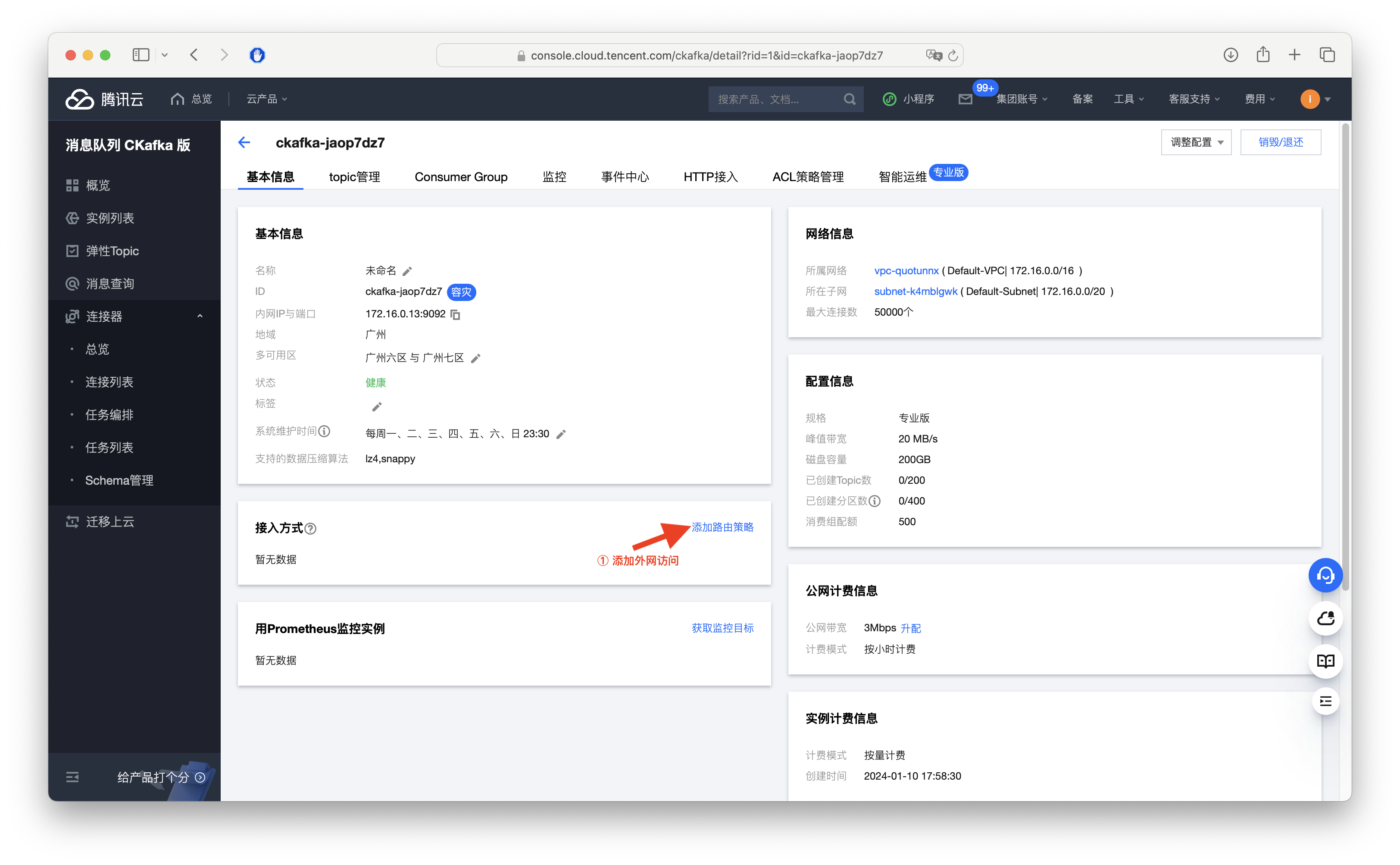

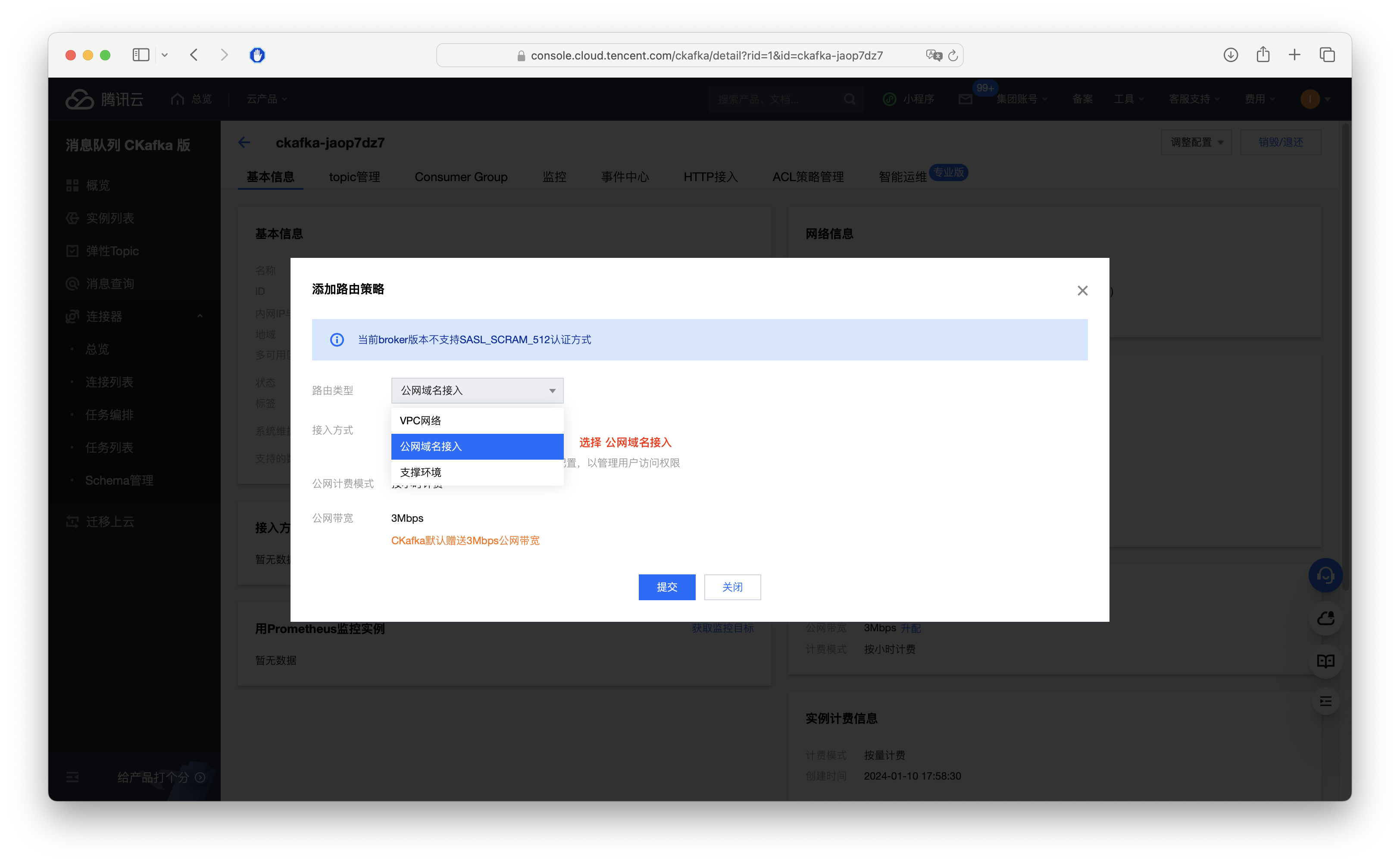

1.1 开通外网访问,选择“公网域名接入”

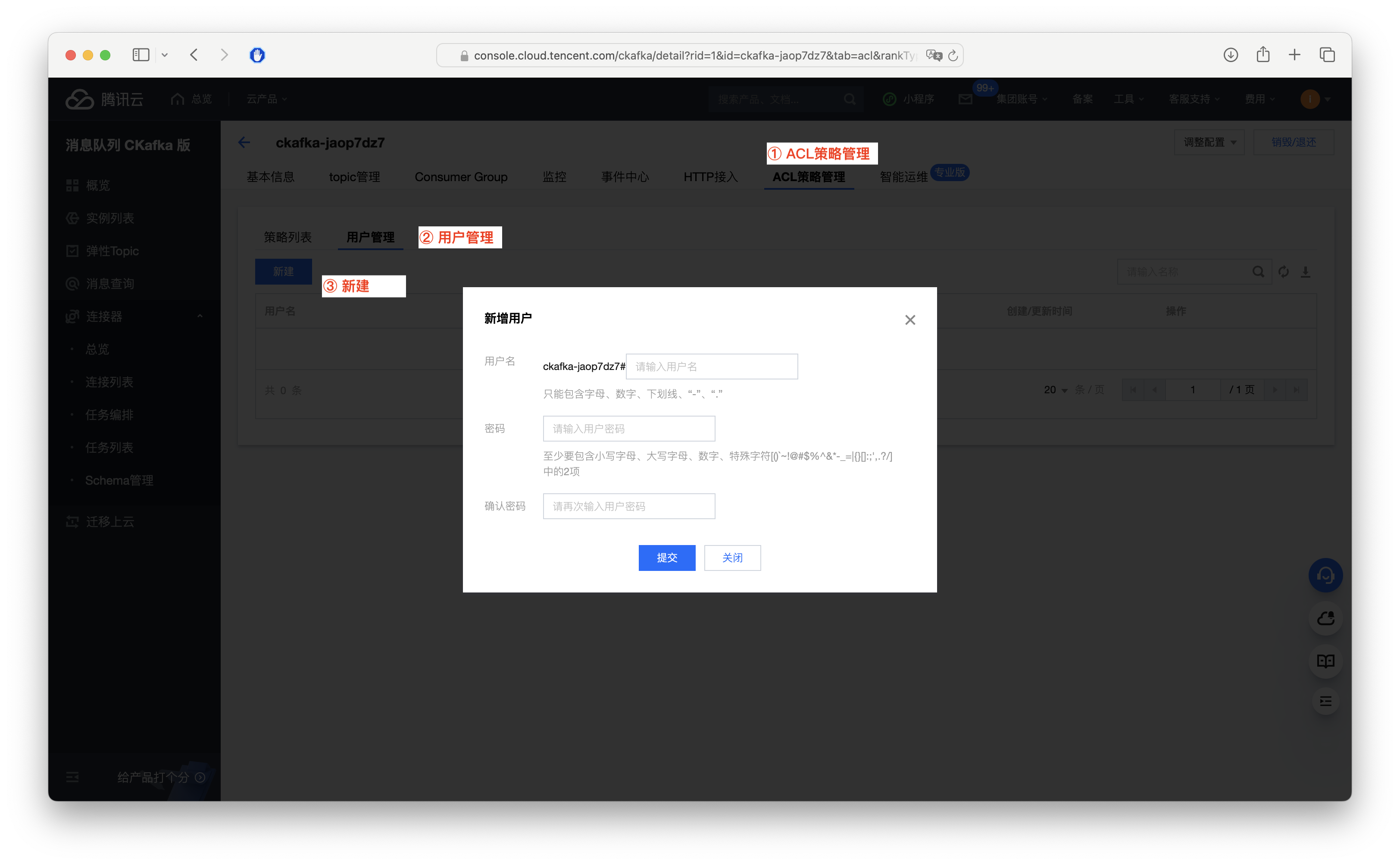

1.2 创建账号密码

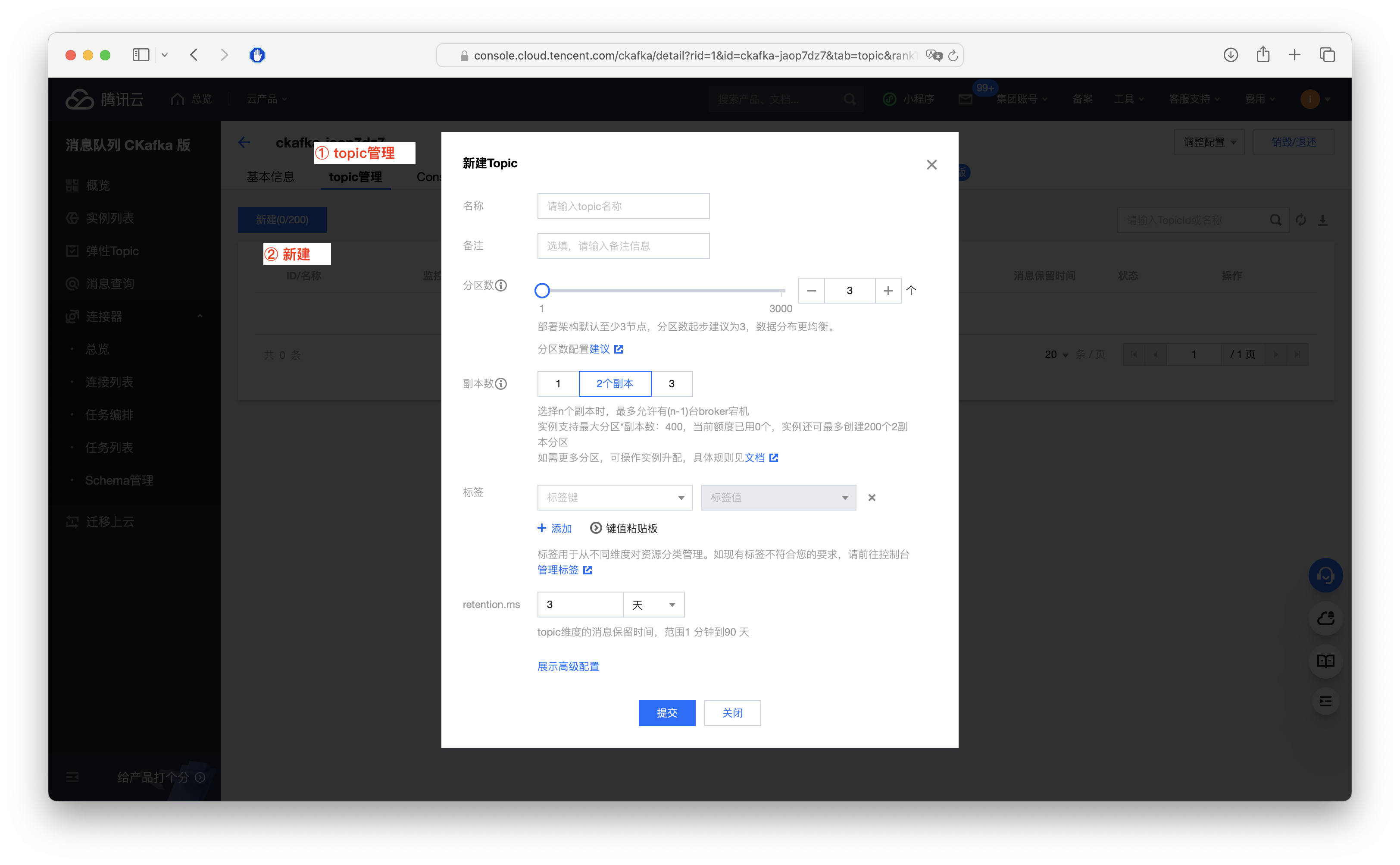

1.3 创建一个测试的 topic

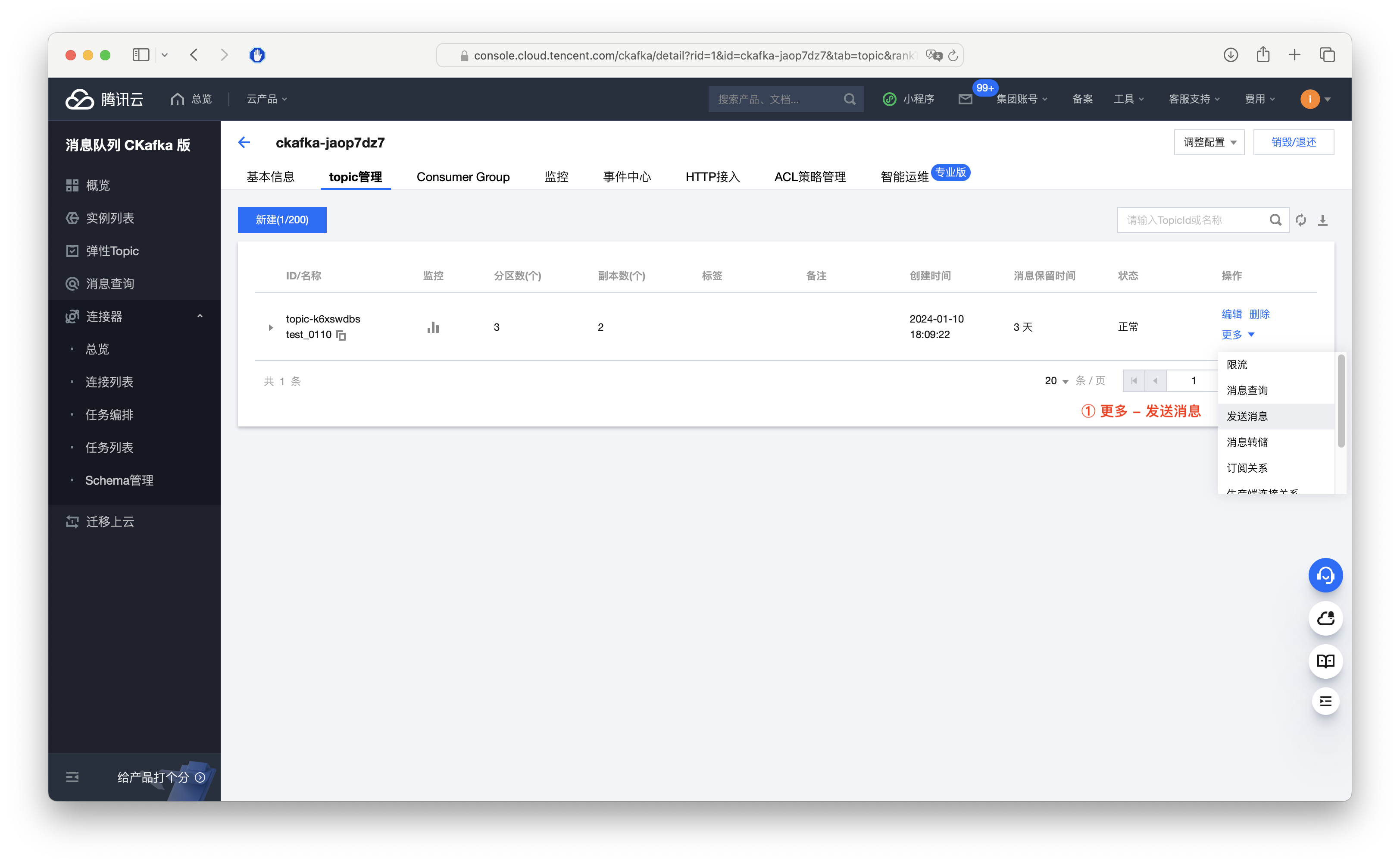

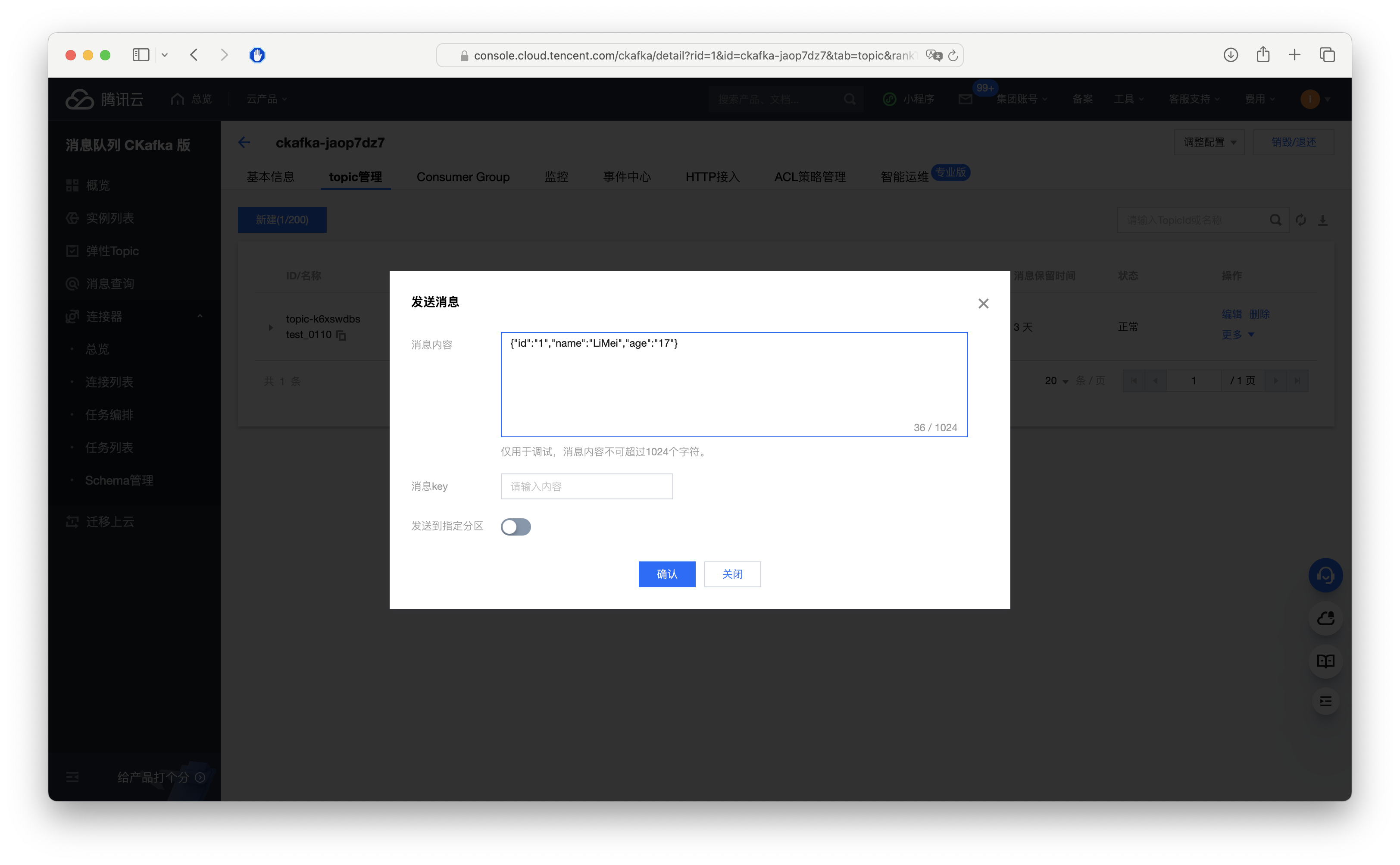

1.4 向这个 topic 发送消息

2. 创建同步任务

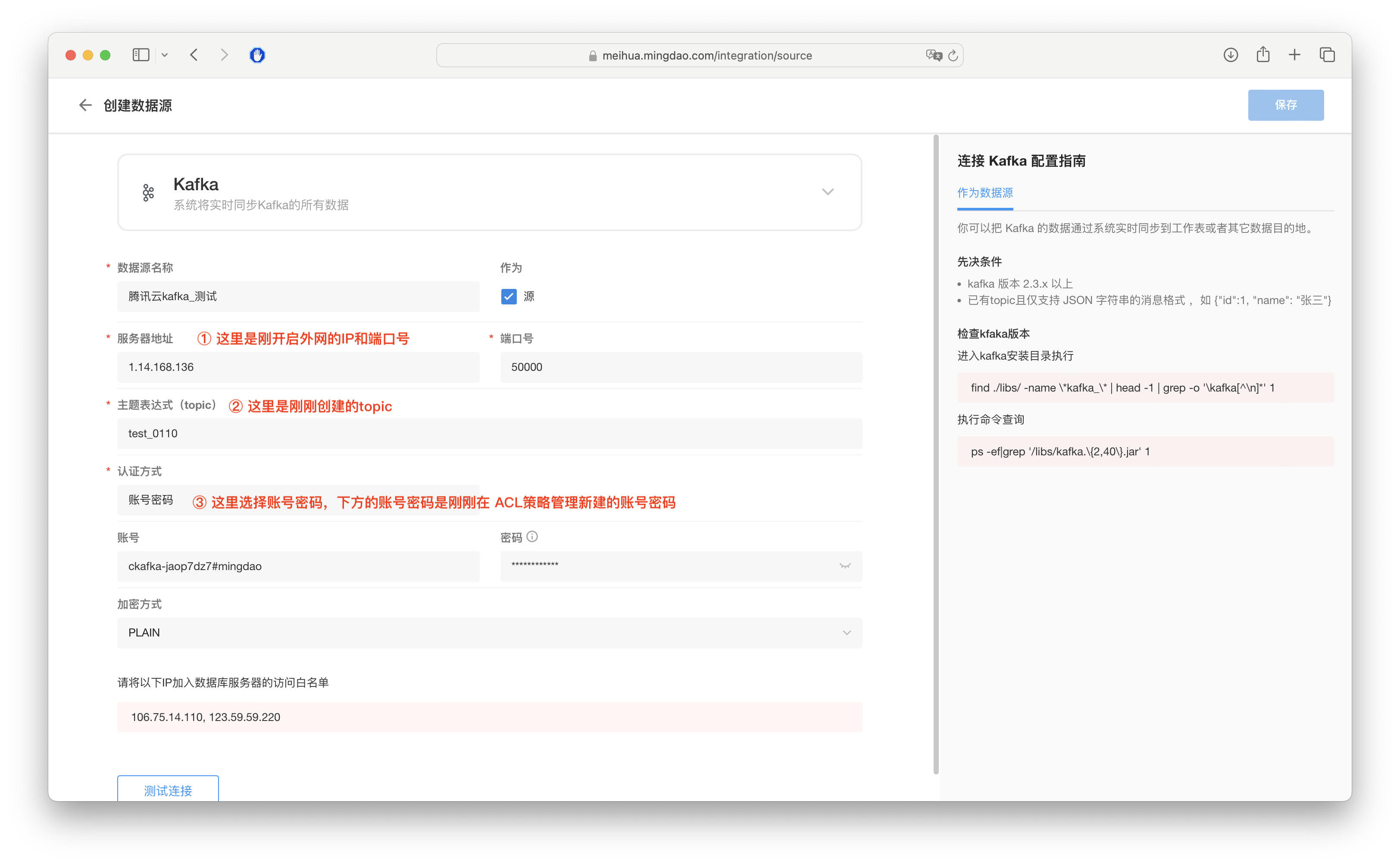

2.1 创建数据源

在集成中心创建同步任务的前提是要先有一个可以连通的数据源,这就是刚刚在 kafka 侧开启外网访问的用处。

- 进入 明道云数据集成页面 https://mingdao.com/integration/source

- 左侧选择 数据集成-数据源,右上角 新建数据源-Kfaka

- 补充信息,刚开启的外网地址、topic、账号密码,点击下方测试连接,测试通过后,右上角保存

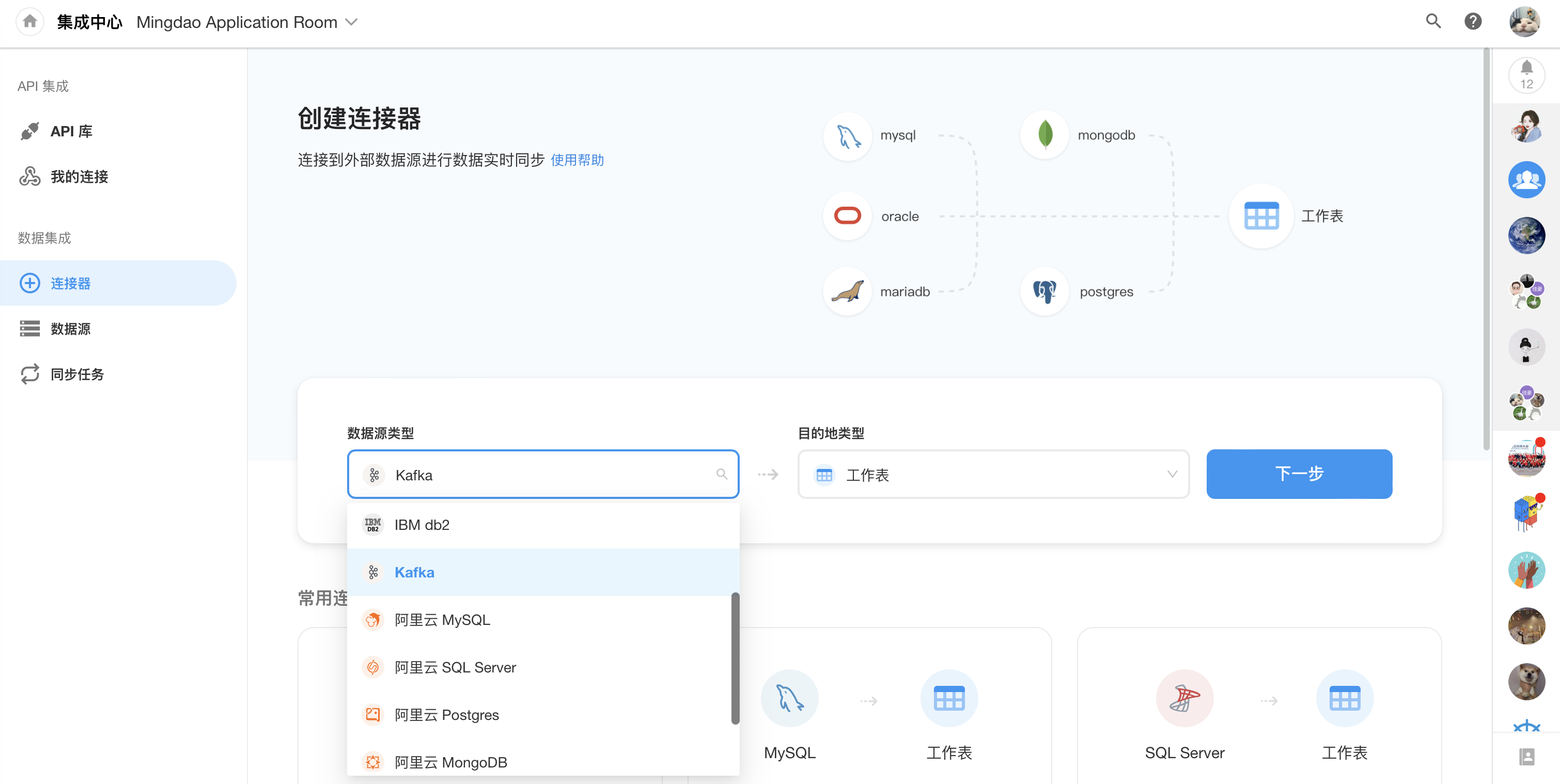

2.2 创建同步任务

1. 选择数据源为 kafka,目的地为工作表

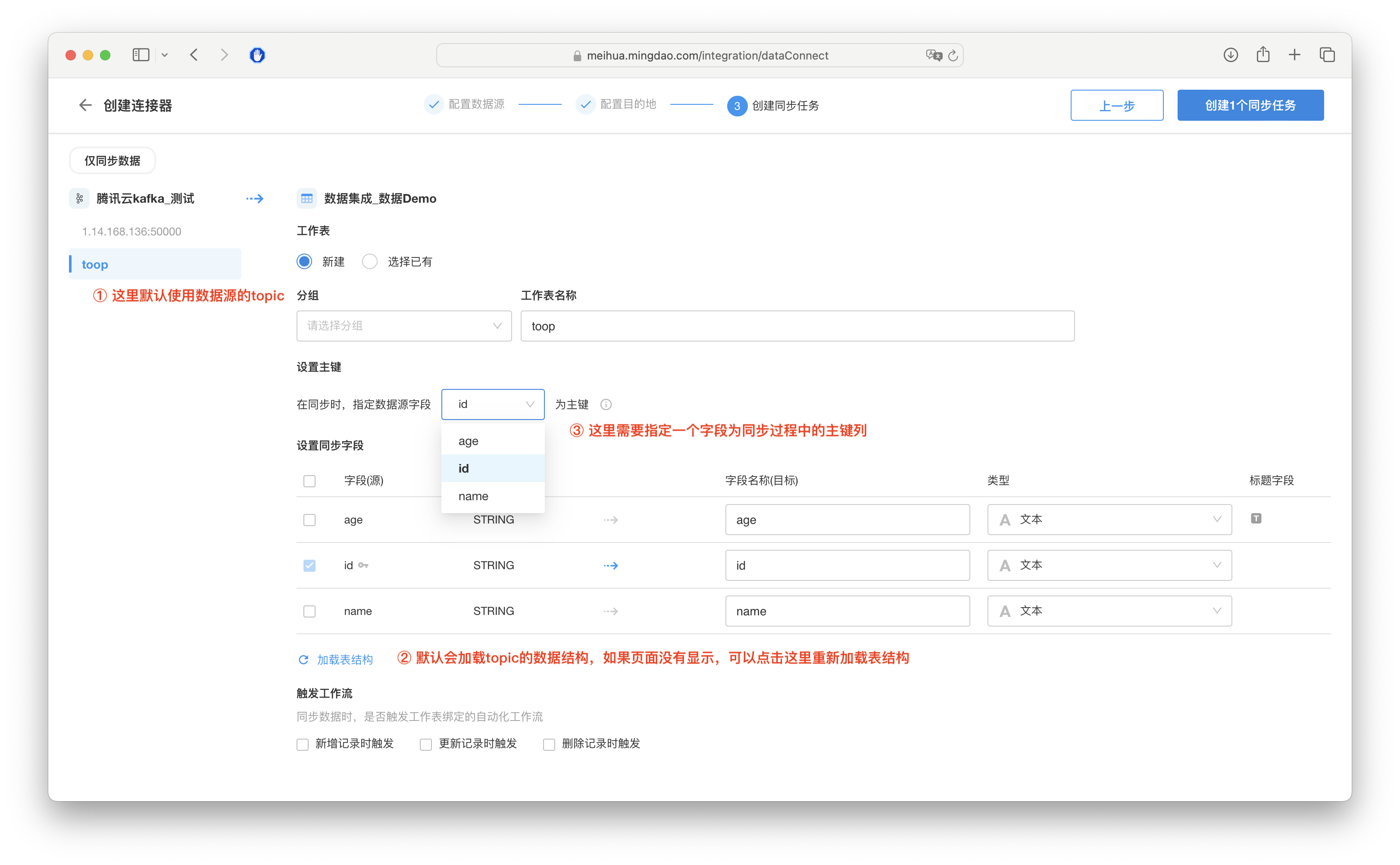

2. 选择目的地表

这里可以选择当前组织内并且自己有权限的任一工作表

3. 创建方式选择仅同步

另外的一个选项“同步时需要对数据进行处理”,是包含了更多节点能力,比如数据筛选、多表连接等,选择仅同步之后,也可以随时去添加这些节点。

4. 配置字段映射

- 默认使用数据源配置的 topic 加载表结构

- 可以点击下方的“加载表结构”重新加载

- kafka 作为数据源的时候,需要指定一列作为主键

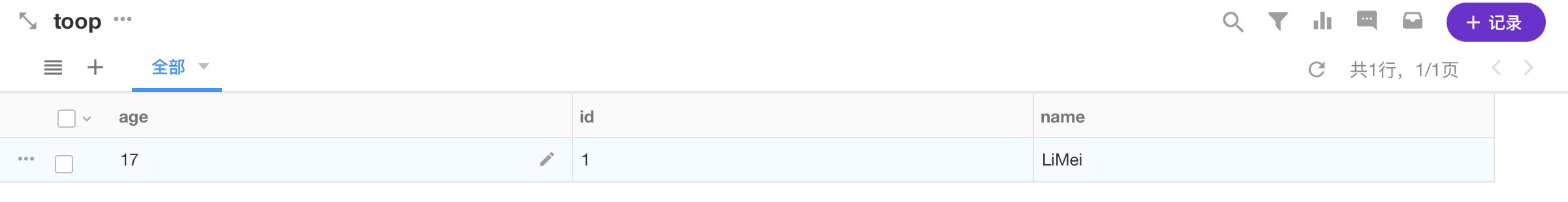

5. 同步后数据